1 Einleitung

Die Digitalisierung hat die Bedürfnisse von Kundinnen und Kunden verändert. Sie sind es sich gewohnt, von überall und jederzeit mit wenig Aufwand auf individualisierte Informationen zugreifen zu können (Chen et al., 2021; Franke & Schulz, 2016; Henman, 2020). Dieses durch die Digitalisierung neu entstandene Bedürfnis bedeutet für die öffentliche Verwaltung einen erheblichen Mehraufwand. Anfragen können nun von überall und zu jeder Zeit gestellt werden.

Chatbots (kurz Bot) bieten hier eine Chance. Damit sind Anwendungen gemeint, welche das Kommunizieren mit technischen Systemen erlauben (IBM, 2023). Unter dem Begriff “chatten” wird ein textorientierter Austausch in Echtzeit von mehreren Teilnehmenden über das Internet verstanden (Reynolds & Anderson, 2015). Chatbots sind Systeme, die für das Abhalten von Dialogen geschaffen sind und über natürlichsprachliche Fähigkeiten verfügen. Sie werden häufig auf Webseiten verwendet, wo sie die Kundschaft über Produkte oder Dienstleistungen aufklärt (Bendel, 2023). Dabei gibt es zwei Arten, wie Chatbots auf Kundenfragen antworten: Chatbots mit vordefinierten Antwortkatalogen (sog. «retrieval based models») stellen eine einfache Form dar (Makasi et al., 2022). Mittels Algorithmen analysiert der Chatbot, welche Antwort am besten auf die Anfrage passt und die entsprechende Antwort wird gesendet. Daneben existieren weit fortgeschrittenere, aber auch aufwendigere Chatbots, die Künstliche Intelligenz (KI) verwenden (sog. «generative models») (Makasi et al., 2022). KI kann als Simulation von menschlichen Intelligenzprozessen durch Computer definiert werden. Somit wird die Funktionsweise von KI derjenigen eines menschlichen Gehirns nachempfunden (Burns & Laskowski, 2023).

Der im November 2022 lancierte «ChatGPT» warf in den Medien riesige Wellen (Zeier, 2022). Der durch das Startup OpenAI erstellte Chatbot hat zur Aufgabe, möglichst natürlich klingende Antworten zu generieren und kann Nutzende beispielsweise dabei unterstützen, Hausaufgaben zu erledigen oder Briefe und Dialoge zu schreiben (Buchmann, 2022). Gemäss dem Staatssekretariat für Bildung, Forschung und Innovation (SBFI) gehören Chatbots aktuell zu den vielversprechensten Entwicklungen der Digitalisierung. Mehrere Schweizer Kantone prüfen zurzeit den Einsatz von Chatbots (SBFI, 2019). Dank ihnen können individuelle Gespräche unabhängig von Ort und Zeit geführt werden. Der digitale Behördenschalter ist so also ständig online verfügbar (Nirala et al., 2022). Zudem können Chatbots dabei helfen, die hohe Anzahl von Anfragen abzuarbeiten, indem sie Kundinnen und Kunden durch das Zusenden von Verlinkungen durch die Webseite navigieren und diese so zu den gewünschten Informationen kommen (Desouza et al., 2020; Henman, 2020). Dadurch, dass Chatbots den Angestellten generelle Anfragen abnehmen, haben diese mehr Zeit, sich spezifischen Anliegen zu widmen (Chen et al., 2021). Somit haben Chatbots hohes Potenzial, einen festen Bestandteil der öffentlichen Verwaltung zu werden (Streicher, 2020; Wang et al., 2021; Wirtz et al., 2021).

Allerdings bestehen auch Bedenken gegenüber Chatbots, insbesondere gegenüber solchen, die KI einsetzen. Oftmals besteht in der Bevölkerung die Annahme, dass Menschen in wichtigen Entscheidungsprozessen ersetzt werden. Viele Personen fühlen sich bei diesem Gedanken unwohl und bezweifeln, dass eine Maschine bessere Entscheidungen treffen kann als ein Mensch (Aoki, 2020).

Bisher gibt es kaum Untersuchungen dazu, wie die Zufriedenheit mit Chatbots aus der Sicht der Kundschaft spezifisch in der öffentlichen Verwaltung ausfällt (Nirala et al., 2022). Gemäss Chen et al. (2021) kann dieser Umstand den Ausbau von hochstehenden qualitativen Dienstleistungen in der öffentlichen Verwaltung verhindern. Dieses Risiko thematisiert auch das SBFI. Es merkt an, dass viele Industrieländer beim Ausbau von KI in der öffentlichen Verwaltung deutlich fortgeschrittener sind als die Schweiz. Wenn die Schweiz nicht intensiver und koordinierter die Möglichkeiten und Risiken von KI diskutiert, wird der Abstand immer grösser (SBFI, 2019).

Hier setzt die vorliegende Studie an, indem sie Wissen generieren soll, wie Bürgerinnen und Bürger auf die öffentliche Leistungserbringung durch Chatbots reagieren. Im Kontext eines Schweizer Strassenverkehrsamtes wird die Reaktion der Kundschaft auf einen vermeintlichen neuen KI-Chatbot untersucht und mit der Zufriedenheit beim Chatten mit einem Menschen verglichen. In Tat und Wahrheit steckt aber auch hinter dem Bot ein Mensch, der chattet. Es soll also gemessen werden, ob sich die Zufriedenheit mit der Dienstleistung unterscheidet, je nachdem ob eine Person das Gefühl hat, sie chatte mit einem Menschen oder einem Bot. Strassenverkehrsämter sind für die Zulassung von Fahrzeugen und Fahrzeugführenden für den Strassenverkehr, administrative Arbeiten bezüglich Führerausweisen und den Einzug von Verkehrssteuern zuständig (Kanton Bern, 2023). Für Strassenverkehrsämter bieten Chatbots eine grosse Chance, da Anliegen meist nicht kompliziert sind und keine individualisierten Antworten benötigen (Kanton Zürich, 2020).

Konkret wird ein Experiment durchgeführt, das herausfinden soll, ob die Kundschaft der öffentlichen Verwaltung zufriedener ist, wenn sie mit einem neu generiertem KI-Chatbot oder einem Menschen via Chat interagiert. Zudem soll untersucht werden, welche weiteren Faktoren die Zufriedenheit mit Chatbots beeinflussen könnten. Insbesondere werden Alter, Geschlecht, technologisches Wissen, Vertrauen ins Internet und soziales Unwohlsein betrachtet. Dementsprechend werden die folgenden beiden Forschungsfragen gestellt:

Inwiefern unterscheidet sich die Zufriedenheit von Kundinnen und Kunden der öffentlichen Verwaltung in Abhängigkeit davon, ob sie der Meinung sind, dass sie mit einem Chatbot oder einem Menschen kommunizieren?

Welches sind mögliche weitere Einflussfaktoren, welche die Zufriedenheit mit der erbrachten Dienstleistung durch Chatbots beeinflussen (Alter, Geschlecht, technologisches Wissen, Vertrauen in das Internet, Soziales Unwohlsein)?

Die Studie soll empirische Befunde dazu liefern, wie Chatbots aus der Sicht der Kundschaft im öffentlichen Sektor wahrgenommen werden. Daraus können keine direkten Handlungsempfehlungen dazu abgeleitet werden, ob Behörden künftig Chatbots einsetzen sollen oder nicht. Vielmehr geht es darum, eine Diskussionsgrundlage für diese komplexe Thematik zu schaffen.

Der Artikel ist folgendermassen gegliedert: Im nächsten Kapitel werden der aktuelle Forschungsstand sowie Praxisbeispiele zum Einsatz von Chatbots im öffentlichen Sektor präsentiert. Danach wird in Kapitel 3 vertieft auf die Rolle der Zufriedenheit der Kundschaft in der öffentlichen Verwaltung eingegangen. Daraus resultieren das Modell und die Hypothesen der vorliegenden Studie (Kapitel 4), welche mit der in Kapitel 5 beschriebenen Methode getestet werden. Die Resultate und deren Diskussion folgen in Kapitel 6 und 7. Der Artikel schliesst mit einem Fazit.

2 Chatbots in der öffentlichen Verwaltung

Dieses Kapitel soll den Einsatz von Chatbots in der öffentlichen Verwaltung aufzeigen. Dabei werden Praxisbeispiele mit wissenschaftlicher Literatur verknüpft. Der erste Abschnitt dient dazu, eine Übersicht zu schaffen, in welchen Bereichen Chatbots bereits zum Einsatz kommen. Im zweiten Abschnitt wird eine interne Perspektive eingenommen und gefragt, ob hybride Teams aus Menschen und Chatbots möglich seien. Im dritten Abschnitt geht es um die externe Sicht auf Chatbots, indem eine kundschaftzentrierte Sicht auf Chatbots in der öffentlichen Verwaltung eingenommen wird.

2.1 Einsatzgebiete

Der erste Chatbot wurde bereits 1966 programmiert (van Noordt & Misuraca, 2019) 2019. Das Ziel war es, herauszufinden, ob Nutzerinnen und Nutzer merkten, ob sie mit einer Maschine oder mit einem Menschen kommunizierten (Weizenbaum, 1966). Auch Forschung rund um KI besteht bereits seit einigen Jahrzenten: Der Mathematiker Alan Turing gab 1947 einen Vortrag zu «Automatic Computing Engine», der als Grundstein der KI-Forschung gesehen wird (McCarthy, 2007). Auch KI wird bereits seit über einem Jahrzehnt genutzt (Sousa et al., 2019). Durch technologische Fortschritte hat das Thema aber vor allem in den letzten Jahren an Relevanz gewonnen (van Noordt & Misuraca, 2019) 2019. In der Privatwirtschaft werden Chatbots bereits häufig eingesetzt. Nirala et al. (2022) identifiziert sechs Sektoren, die bereits Chatbots einsetzen. Dazu gehört beispielsweise die Banken- und Versicherungsbranche, wo Chatbots die Kundschaft unter anderem dabei unterstützt, verlorene Kreditkarten zu melden, oder im Verkauf, wo Chatbots personalisiertes Marketing ermöglichen oder Informationen zum Versandprozess bereitstellen.

Auch im öffentlichen Sektor wird der Einsatz von Chatbots immer häufiger diskutiert (Neumann, Guirguis, & Steiner, 2022; Androutsopoulou, Karacapilidis, Loukis, & Charalabidis, 2019). Diese kommen hier jedoch noch weit weniger häufig zum Einsatz als in der Privatwirtschaft. Insbesondere auf Gemeindeebene sind Chatbots noch rar (Nirala et al., 2022), obwohl diese die erste Anlaufstelle für die Bevölkerung darstellen könnten. In der Schweiz gibt es dennoch verschiedene Anwendungsbeispiele in Städten und Gemeinden oder Behörden. Auch das Strassenverkehrsamt des Kantons Aargau nutzt einen Chatbot, welcher Standard-Antworten auf vorgegebene häufig gestellte Fragen gibt. Falls die Anfrage nicht beantwortet werden kann, wird sie gespeichert und ein Mensch kümmert sich um das Anliegen (Kanton Aargau, 2023). Das regionale Arbeitsvermittlungszentrum (RAV) des Kantons Basel-Landschaft setzt einen Chatbot ein, der sich um generelle Kundenanliegen kümmert (Kanton Basel Landschaft, 2023).

Es besteht ein weitverbreitetes Verständnis dafür, dass KI den öffentlichen Sektor nachhaltig verändern werde, indem eine Verschiebung von einer Internet-basierten zu einer KI-basierten Informationsgesellschaft stattfinde (Ahn & Chen, 2020; Berryhill et al., 2019). Zusätzlichen Aufschwung erhielt die Chatbot-Diskussion durch die Covid19-Pandemie. Aufgrund von Social Distancing stiegen Online-Anfragen an die öffentliche Verwaltung. Chatbots waren hier besonders hilfreich, weil sie Terminvereinbarungen oder Statusabfragen bearbeiten konnten (Kohne et al., 2020).

2.2 Organisationsinterne Auswirkungen des Chatbot-Einsatzes

Der grösste Vorteil, den Chatbots Verwaltungen und ihren Mitarbeitenden bieten, ist die Möglichkeit, repetitive Arbeiten abgeben zu können (Makasi et al., 2022; Maragno et al., 2022; Nirala et al., 2022). Dies zeigt ein Chatbot der Steuerverwaltung Australiens. Dieser beantwortete 75 bis 90 Prozent der ersten Kontaktanfragen, was dazu führe, dass die Telefonanrufe bei der Steuerverwaltung um sieben Prozent zurückgingen (Henman, 2020; Nirala et al., 2022).

Mehr (2017) listet konkrete Aufgaben auf, die an Chatbots abgegeben werden könnten:

Beantwortung von Fragen, Beschwerden und Anfragen

Suche in Dokumenten (einschliesslich juristischer Dokumente) und Bereitstellung von Leitlinien zum Ausfüllen von Formularen

Entgegennahme von Anfragen und Weiterleitung an die zuständige öffentliche Verwaltung

Übersetzung behördlicher Informationen

Ausarbeitung von Dokumenten mit Antworten häufige Fragen

Chatbots können Anfragen schriftlich oder per Telefon entgegennehmen. Nutzerinnen und Nutzer erhalten sofort eine Antwort, was die Kommunikation zwischen der öffentlichen Verwaltung und der Bevölkerung verbessert und dadurch die Transparenz fördert (Nirala et al., 2022). Durch die Abgabe repetitiver Arbeiten reduzieren sich zudem die Dienstleistungskosten für die öffentliche Verwaltung (Makasi et al., 2022).

In der Praxis werden Chatbots auch dafür eingesetzt, um den Digitalisierungsprozess von öffentlichen Dienstleistungen voranzutreiben. Dies ist beispielsweise beim «WienBot», dem Chatbot der Stadt Wien, der Fall (Stadt Wien, 2018). Da Chatbots zum Lernen eine grosse Menge an Daten benötigen, müssen Datensätze kategorisiert und bereinigt werden (Androutsopoulou et al., 2019; Maragno et al., 2022). Während dies sehr zeitaufwändig ist, profitieren öffentliche Verwaltungen aber auch von besser aufbereiteten Datensätzen, um diese als Grundlage für den Chatbot zu nutzen. Hinzu kommt, dass Informationen nicht verloren gehen, wenn beispielsweise Mitarbeitende in Rente gehen (Maragno et al., 2022). Gerade in Zeiten von Fachkräftemangel ist diese ein erfreulicher Nebeneffekt.

Die Einführung von Chatbots ist aber nicht nur zeitaufwändig, sondern benötigt auch viel Knowhow. Chatbots müssen von Menschen trainiert werden (Nirala et al., 2022), damit sie später möglichst präzise auf Anfragen aus der Bevölkerung antworten können. Dies kreiert neue Job-Profile. Maragno et al. (2022) sieht zwei Möglichkeiten, wie die neue Aufgabe des «Chatbot-Trainierens» aufgeteilt werden kann: Entweder gibt es spezifische Teams, die sich ausschliesslich damit befassen, die Datenbank des Chatbots zu erweitern, oder alle Mitarbeitenden setzt einen Teil ihrer Arbeitszeit dafür ein (Maragno et al., 2022).

Dieses Trainieren des Chatbots impliziert bereits eine gewisse Zusammenarbeit zwischen Mensch und Maschine. In der Literatur besteht mit der Automatisierung ein traditioneller Ansatz, wie eine solche Zusammenarbeit aussehen könnte. Mit «Automatisierung» ist gemeint, dass einzelne Aufgaben komplett an einen Chatbot abgegeben werden (Veale, 2019). Ein Chatbot beantwortet beispielsweise Anfragen, welche lediglich ein Sammeln von verfügbaren Informationen bedürfen, selbstständig (Vassilakopoulou et al., 2022). Stösst er an seine Grenzen, wird die Anfrage an einen Menschen weitergeleitet. Die zuständigen Verwaltungsmitarbeitenden können den Chatverlauf einsehen und sehen so, um welches Anliegen es sich handelt und welche Informationen die Antragstellenden bereits erhalten haben (Vassilakopoulou et al., 2022).

Automatisierung führt bei vielen Verwaltungsmitarbeitenden aber auch zur Angst des Jobverlusts (van Noordt & Misuraca, 2020). Unter anderem aus diesem Grund wird anstatt von Automatisierung immer häufiger von «Augmentation», also von einer ergänzenden Funktion von Chatbots gesprochen (Veale, 2019). Es geht also nicht mehr darum, Aufgaben als ganze an Maschinen abzugeben, sondern um gesamtheitliche Zusammenarbeitskonzepte für Menschen und KI (Maragno et al., 2022). Beispielsweise können Verwaltungsmitarbeitende bei Gesprächen mit Einwohnerinnen und Einwohnern selbst den Chatbot nutzen und so aktuelle Informationen konsultieren (Vassilakopoulou et al., 2022). Dadurch soll sich die Dienstleistungsqualität der öffentlichen Verwaltung erhöhen. Eine andere Möglichkeit, Chatbots im Sinne der «Augmentation» zu nutzen, ist eine Art Monitoring: Wenn ein Chatbot plötzlich eine Vielzahl an Anfragen zu einem spezifischen Thema erhält, kann dies beipsielsweise ein Indiz dafür sein, dass falsche oder veraltete Informationen publiziert worden sind (Vassilakopoulou et al., 2022).

Solche hybriden Teams bedingen in der öffentlichen Verwaltunge ein grundsätzliches Überdenken der klassischen Führungsrolle (van Noordt & Misuraca, 2020) und der Arbeitsaufteilung zwischen Menschen und Chatbots (Janssen et al., 2022; Wirtz et al., 2018). In einem zweiten Schritt müssen Mitarbeitende eingehend zur Zusammenarbeit mit Chatbots geschult werden (Ahn & Chen, 2020). Zudem muss für jeden Fall evaluiert werden, wie eine ideale Balance zwischen Automatisierung und Augmentation erreicht werden kann (Raisch & Krakowski, 2021). Auf diese Weise können öffentliche Verwaltungen vom grossen Potenzial von hybriden Teams profitieren (Baird & Maruping, 2021; Raisch & Krakowski, 2021; Wilson & Daugherty, 2018). Gerade in der eher veränderungsresistenten und bürokratischen Verwaltung können diese Voraussetzung grosse Hürden darstellen (Ashaye & Irani, 2019; Meijer, 2015).

2.3 Externe Auswirkungen des Chatboteinsatzes

«Bessere Dienstleistungen» ist der grösste Vorteil von Chatbots aus Sicht der Nutzerinnen und Nutzer (Maragno et al., 2022). Dies umfasst unter anderem folgende Aspekte:

Anfragen können zeitunabhängig bearbeitet werden (Henman, 2020; Stadt Wien, 2018).

Anfragen werden schneller bearbeitet (Makasi et al., 2022; Nirala et al., 2022).

Nutzerinnen und Nutzer erhalten im besten Fall ausschliesslich Informationen, die für sie relevant sind. Dies führt zu weniger Überforderung aufgrund zu vieler Information (van Noordt & Misuraca, 2019).

Daneben besteht der Vorteil, dass Chatbots ohne viel Aufwand die Anfragen eines Grossteils der Bevölkerung bearbeiten können, beispielsweise weil Fremdsprachen für sie keine Hürde darstellen (Androutsopoulou et al., 2019)government agencies have also started adopting various Artificial Intelligence (AI).

Allerdings haben Chatbots durchaus sprachliche Schwierigkeiten. Chatbots, die beispielsweise orthografische Fehler nicht als solche erkennen, können zu einem unbefriedigenden Erstkontakt mit der öffentlichen Verwaltung führen, da die Anliegen nicht richtig erkennt werden (Simonsen et al., 2020). Hinzu kommen gemäss Simonsen et al. (2020) drei weitere sprachliche Schwierigkeiten für Nutzerinnen und Nutzer beim Umgang mit Chatbots: Erstens besteht die Möglichkeit, dass ein Chatbot das Kernanliegen einer Frage nicht versteht. Im Rahmen der Studie von Simonsen et al. (2020) fragte ein Nutzer «Wie hoch sind die Kinderzulagen in diesem Jahr?». Der Chatbot antwortete mit einer Erklärung zu Kinderzulagen allgemein, jedoch nicht zu deren Höhe. Zweitens kann es sein, dass ein Chatbot eine Frage nicht mit der entsprechenden Dienstleistung in Verbindung bringt. Dieser Fall kann eintreten, wenn Nutzerinnen und Nutzer die einzelnen Dienstleistungen der öffentlichen Verwaltung zu wenig verstehen, um konkrete Fragen zu stellen. Drittens besteht die Möglichkeit, dass ein Chatbot logische Mängel aufweist. In der Studie von Simonsen et al. (2020) fragte ein Nutzer «Kann eine junge und beeinträchtigte Person mit einer ausländischen alleinstehenden Mutter verheiratet sein und Kinderzulagen beziehen?”. Der Chatbot verstand nicht, dass man als “alleinstehende Mutter” verheiratet sein kann. Dies führte dazu, dass der Chatbot Informationen zur Verfügung stellte, die nicht auf den konkreten Fall anwendbar waren. Dieser Mangel ist der gravierendste, da die Informationen zu allgemein sind (Makasi et al., 2022) und Falschifnormationen bereitgestellt werden (Simonsen et al., 2020).

Neben sprachlichen Hürden besteht die Schwierigkeit, dass Nutzerinnen und Nutzer menschliche Servicekräfte gegenüber Chatbots grundsätzlich präferieren. Dies zeigt eine Studie von Userlike (2023), bei der 60 Prozent der Befragten (n = 415) lieber auf einen Menschen warteten als mit einem Chatbot zu interagieren. Der Hauptgrund dafür ist, dass sie den Eindruck hatten, dass Chatbots ihnen nur eingeschränkt weiterhelfen könnten (Userlike, 2023). Gleichzeitg wird das Vertrauen in Chatbotinteraktionen durch menschliche Eigenschaften sowie sozialer Präsenz positiv beeinflusst (Yen & Chiang, 2021). Wie Madhavan & Wiegmann (2007) beschreiben, unterliegt die Interaktion zwischen Menschen und automatisierten Systemen (wie Chatbots) den gleichen Normen wie Interaktionen zwischen Menschen. Wenn die Quelle der Nachricht bekannt ist, führt dies daher zu einer unterschiedlichen Wahrnehmung der Zuverlässigkeit und der Glaubwürdigkeit, da die Informationen durch die Nutzerinnen und Nutzer gefiltert werden (Madhavan & Wiegmann, 2007).

Eine zusätzliche Herausforderung für den Einsatz von Chatbots besteht im öffentlichen Sektor darin, dass es sich bei vielen Informationen um schützenswerte Daten handelt, beispielsweise zu Arbeitslosigkeit oder Pflege (Makasi et al., 2022). Die Organisationen müssen daher ihren Kundinnen und Kunden glaubhaft versichern, dass ihre persönlichen Informationen nicht zweckentfremdet werden, um Vertrauen in den Chatbot zu schaffen (Yen & Chiang, 2021).

Es stellt sich die Frage, wie Chatbots im öffentlichen Sektor konzipiert werden müssen, damit sie für die Nutzenden den grösstmöglichen Nutzen haben. Die Literatur liefert diesbezüglich verschiedene Indikatoren, welche die Zufriedenheit der Nutzenden positiv beeinflussen. Diese Indikatoren sind in Tabelle 1 zusammengefasst.

Tabelle 1

Indikatoren zur Erhöhung der Zufriedenheit.

| INDIKATOR | BESCHREIBUNG |

|---|---|

| Schnelligkeit | Chatbots sollen in der Lage sein, auch bei grosser Nachfrage schnell auf Anfragen zu zu antworten (Espig et al., 2019; Niralaet al., 2022). |

| Irritationsresistenz | Chatbots sollen mit Rechtschreibfehlern und Beleidigungen umgehen können (Espig et al., 2019; Simonsen et al., 2020). |

| Verlässlichkeit | Verschiedene Studien zeigen, dass die Zufriedenheit mit Chatbots eng damit zusammenhängt, ob diese korrekte und verlässliche Antworten liefern (Aoki, 2020; Kohne et al., 2020). Kann ein Chatbot eine Anfrage nicht verstehen, sind Hilfestellungen zu liefern, damit Nutzerinnen und Nutzer ihre Anfrage neu formulieren können (Simonsen et al., 2020). Limitationen des Chatbots sollen ausdrücklich als solche gekennzeichnet werden (Simonsen et al., 2020). |

| Individualisierung | Nutzerinnen und Nutzer möchten bedarfsgerecht addressiert werden und nicht das Gefühl haben, Teil eines Kundensegments zu sein (Franke & Schulz, 2016). Die Kommunikation des Chatbots soll also genau zum Kontext des Anliegens passen (Franke & Schulz, 2016). |

| Datensicherheit | Den Kontext eines Anliegens zu verstehen, ist teilweise nur möglich, wenn ein Chatbot Einsicht in persönliche Daten der Nutzerinnen und Nutzer hat. Dies kann beispielsweise durch ein Login erreicht werden (Makasi et al., 2022; Simonsen et al., 2020). Es muss sichergestellt zudem werden, dass die Informationen der Nutzerinnen und Nutzer nicht an Dritte weitergegeben werden (Userlike, 2023). Dies ist insbesondere bei Behörden ein wichtiger Faktor, da mit schutzwürdigen Daten gearbeitet wird. |

| Menschen-Ähnlichkeit | Ein hochwertiger Chatbot zeichnet sich durch einen freundlichen und einfühlsamen Umgang aus. Merken Nutzerinnen und Nutzer, dass ein Chatbot unsensibel auf ihre Anfrage reagiert, sinkt ihre Zufriedenheit (Aoki, 2020). Empathie – ein menschlicher Charakterzug – kann durch künstliche Intelligenz simuliert werden (Aoki, 2020). |

| Maschinen-Ähnlichkeit | Trotzdem sollten Chatbots nicht zu menschlich wirken, da Nutzerinnen und Nutzer ansonsten vergessen, dass sie mit einer Maschine mit gewissen Limitationen kommunizieren (Simonsen et al., 2020). |

2.4 Einflussfaktoren

Neben diesen zufriedenheitsfördernden Eigenschaften von Chatbots bestehen gemäss Literatur weitere Einflussfaktoren auf der Seite der Nutzerinnen und Nutzer, die sich auf deren Zufriedenheit auswirken.

2.4.1 Alter

Hoff & Bashir (2015) haben im Rahmen einer Literaturrecherche 127 Publikationen zum Vertrauen in Automatisierungen untersucht. Die Resultate zeigen, dass das Alter eine signifikante Einflussvariable sei. Die verschiedenen Studien weisen aber abweichende Resultate auf, was darauf schliessen lässt, dass das Alter unterscherschiedlichen Einfluss in den verschiedenen Einsatzgebieten von Chatbots hat. Morelli et al. (2020), die in ihrer Studie die Zufriedenheit der Kundschaft von Chatbots in der Mobilitätsbranche untersuchten, konnten hingegen keinen Zusammenhang zwischen Alter und Wahrnehmung von Chatbots feststellen. Bei dieser Studie gehörte allerdings die Mehrzahl der Probanden jüngeren Generationen an.

2.4.2 Geschlecht

Bezüglich des Geschlechtes konnten Hoff & Bashir (2015) keine signifikanten Unterschiede finden. Die Geschlechter reagierten gleich auf die Automatisierung. Wang et al. (2021) fanden hingegen Unterschiede: Männer empfanden die Benutzung eines Voice-Chatbots insgesamt sinnvoller als Frauen – wobei die Frauen das Gespräch mit dem Voice-Chatbot mehr genossen haben. Geschlechterspezifische Unterschiede im IT-Kontext sind gemäss Wang et al. (2021) noch unklar und zu wenig untersucht.

2.4.3 Vertrauen ins Internet

Eine repräsentative Umfrage in der Schweiz (n = 1’120) zeigt, dass 61 Prozent der Bevölkerung nur rund die Hälfte der Inhalte im Internet als glaubwürdig einstuft und ihr Vertrauen schenkt (Credit Suisse, 2022). Die Umfrage zeigt aber auch, dass gerade behördlichen Webseiten hohes Vertrauen geschenkt wird. Da Chatbots in Webseiten integriert sind, sind die Resultate dieser Studie auch für den Diskurs rund um Chatbots relevant. Eine Studie der ZHAW zeigt zudem, dass das Unwissen darüber was mit den persönlichen Daten geschieht, eine grosse Sorge der Nutzerinnen und Nutzer ist (Monard et al., 2021). Nur 18 Prozent der Probandinnen und Probanden vertrauen darauf, dass die Daten bei einer Interaktion sicher sind – jedoch wären 75 Prozent bereit, sich für eine Konversation mit einem Chatbot zu authentifizieren.

2.4.4 Technologisches Wissen

Meuter et al. (2003) zeigen, dass manglendes technologisches Wissen das grösste Hindernis ist, Chatbots zu nutzen.

2.4.5 Soziales Unwohlsein/Sozialinteraktion

Das soziale Unwohlsein zeichnet sich dadurch aus, dass sich Betroffene vor sozialen Situationen fürchten und versuchen, diese zu vermeiden. Jede dritte Person zeigt Anzeichen von sozialem Unwohlsein, am häufigsten betroffen sind Personen im Alter von 16 bis 29 Jahre (Heimberg, Hofmann, Liebowitz, & Schneier, 2014). Gerade für Behörden, die mit sämtlichen Bevölkerungsgruppen interagieren, ist es wichtig, auf solche Gegebenheiten zu reagieren (Meuter et al., 2003). Chatbots bieten hier Chancen: Følstad, Nordheim & Bjørkli (2018) fanden Evidenz dafür, dass sich die Probandinnen und Probanden wohler fühlten, wenn sie wusseten, dass sie mit einem Chatbot kommunizierten und nicht mit einer echten Person. Sie verspürten weniger Druck, ihr Anliegen schön auszuformulieren. Ebenfalls empfanden sie geringeren Druck, schnell zu antworten und konnten sich mehr Zeit nehmen, die Antworten zu lesen. Bei Hwang & Won (2021) mussten Probandinnen und Probanden einen Brainstorming-Prozess entweder mit einem Chatbot oder einer Person simulieren. Dabei kam heraus, dass Personen, die sich sozial nicht wohlfühlten, kommunikativer und kreativer waren, wenn sie mit einem Chatbot kommunizierten anstatt mit einer Person. Eine Erklärung ist, dass gemäss den Probandinnen und Probanden Chatbots weniger kritische Beurteilungen abgaben als Menschen.

3 Modell und Hypothesen

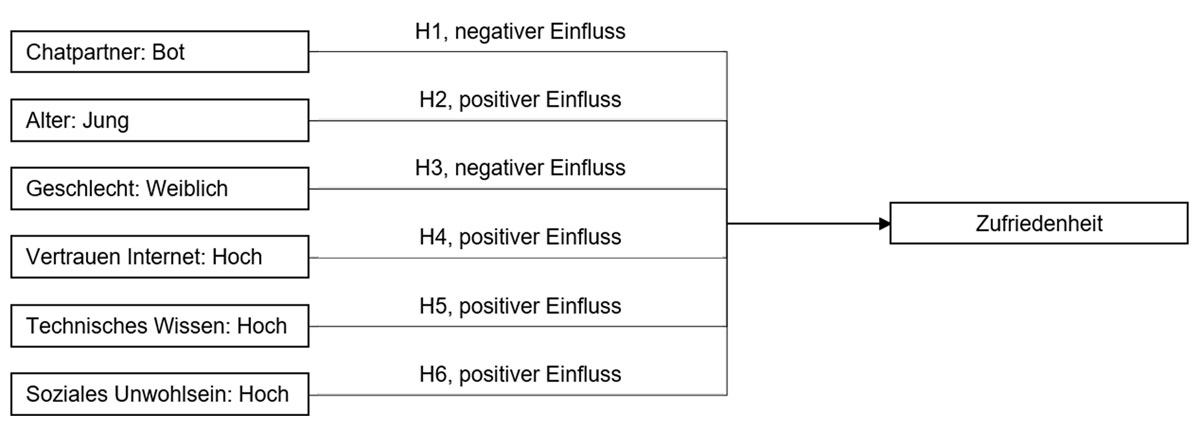

Aus Kapitel 3 kann das Modell der vorliegenden Studie abgeleitet werden (vgl. Abbildung 1). Dabei bildet Zufriedenheit die abhängige Variable und Alter, Geschlecht, Vertrauen in Informationen aus dem Internet, technisches Wissen und soziales Unwohlsein die unabhängigen Variablen. Zudem besteht die Annahme, dass das Wissen, ob man sich mit einem Chatbot oder einem Menschen unterhält, ebenfalls einen Einfluss auf die Zufriedenheit hat und eine unabhängige Variable darstellt.

Abbildung 1

Modell

Dementsprechend werden folgende Hypothesen formuliert:

H1 Die Zufriedenheit bei der Nutzung einer Chatfunktion ist tiefer, wenn die Interaktion mit einem Bot stattfindet als mit einem Menschen.

H2 Die Zufriedenheit bei der Nutzung einer Chatfunktion ist bei jüngeren Personen höher als bei älteren.

H3 Die Zufriedenheit bei der Nutzung einer Chatfunktion ist bei weiblichen Personen tiefer als bei männlichen.

H4 Die Zufriedenheit bei der Nutzung einer Chatfunktion ist bei Personen mit einem hohen Vertrauen in Informationen aus dem Internet höher als bei Personen mit tiefem Vertrauen.

H5 Die Zufriedenheit bei der Nutzung einer Chatfunktion ist bei Personen mit hohem technischem Wissen höher als bei Personen mit tiefem technischem Wissen.

H6 Die Zufriedenheit bei der Nutzung einer Chatfunktion ist bei Personen mit hohem sozialem Unwohlsein höher als bei Personen mit tiefem sozialem Unwohlsein.

4 Methode

Zur Beantwortung der Forschungsfragen wurde am 28. und 29. April 2022 ein Online-Experiment durchgeführt. Dieses erfüllt die Bedingungen eines Laborexperiments, da es sich um eine geschützte Umgebung handelte und es in einem vollständig kontrollierten Umfeld stattfand (Balzert, Schröder, & Schäfer, 2017, S. 276).

Zur Rekrutierung im Umfeld der Autorinnen und Autoren wurden vorgängig E-Mails versendet. In der Nachricht befand sich ein Link zur Terminkoordinationsplattform «Doodle», über welche sich die Probandinnen und Probanden für einen Termin einschreiben konnten. Die einzigen Kriterien für die Teilnahme am Experiment waren ein Internetzugang und ein Wohnsitz in der Schweiz. Auch wurde gezielt versucht, Personen aus allen Altersgruppen zu rekrutieren. Die Stichprobe umfasste 30 Personen, wobei die Gruppenzuteilung zufällig geschah. Für das Experiment wurde eine einfache Chatfunktion auf der Plattform «tawk.to»1 aufstellt, die über einen Direktlink erreichbar war. Der Link wurde den Probandinnen und Probanden am Tag des Experimentes per Mail zugestellt. Ebenfalls erhielten sie eine Liste mit häufig gestellten Fragen ans Strassenverkehrsamt des Kantons Bern, die als Hilfestellung dienen sollte, falls ihnen während des Experiments keine Fragen einfallen sollten. Die Teilnehmenden konnten während des Experiments aber auch eigene Fragen formulieren.

Zu Beginn des Experimentes wurde den Teilnehmenden eine Startnachricht zugestellt, in der ihr Chatgegenüber vorgestellt wurde (Tabelle 2). Dabei wurde zufällig zwischen einer Angestellten (fiktiver Name «Sandra Muster») und dem neuen KI-Chatbot des Strassenverkehrsamtes unterschieden. Daraus ergaben sich die Experimentalgruppe (Bot) und die Kontrollgruppe (Mensch). Im Hintergrund wurde die Chatunterhaltung jedoch in jedem Fall von einem Menschen bedient (primär durch die Angestellte, in einzelnen Ausnahmefällen durch einen geschulten Forschenden), um zu gewährleisten, dass sich der Chatbot in allen Fällen gleich verhielt. Die Teilnehmenden wurden über die genaue Absicht des Experiments in Unkenntnis belassen und konnten frei mit dem jeweiligen Gegenüber interagieren, indem sie gebeten wurden, Fragen zu stellen. Die Experimentalgruppe “Bot” wurde bis zum Ende im Glauben gelassen, mit einem Chatbot zu kommunizieren. Die Unterhaltungen dauerten im Durchschnitt zehn Minuten.

Tabelle 2

Startnachrichten für Experiment.

| STARTNACHRICHT MENSCH | STARTNACHRICHT BOT |

|---|---|

| Guten Tag. Mein Name ist Sandra Muster und ich bin Mitarbeiterin des Strassenverkehrs- und Schifffahrtsamtes und beantworte heute Ihre Fragen. Wie kann ich Ihnen behilflich sein? | Guten Tag. Ich bin der digitale Assistent des Strassenverkehrs- und Schifffahrtsamtes und beantworte Ihre Fragen. Ich bin noch jung, aber lerne dank Ihren Eingaben laufend dazu. Bitte stellen Sie mir Ihre Frage. |

Die beiden Gruppen sind in Bezug auf Anzahl, Alter, Digitalaffinität und Bildungsstand vergleichbar (siehe Tabelle 3). Bei der Geschlechterverteilung besteht ein gewisses Ungleichgewicht (Gruppe «Mensch»: 15 Personen, davon 10 weiblich und 5 männlich; Gruppe «Bot»: 15 Personen, davon 4 weiblich und 11 männlich).

Tabelle 3

Demografie der Gruppen.

| FAKTOR | GRUPPE BOT | GRUPPE MENSCH |

|---|---|---|

| Alter | Mittelwert: 34.47 | Mittelwert: 35.13 |

| Standardabweichung: 14.31 | Standardabweichung: 14.54 | |

| Digitalaffinität | Mittelwert: 6.93 | Mittelwert: 7.00 |

| Standardabweichung: 0.26 | Standardabweichung: 0.00 | |

| Bildungsstand | Mittelwert: 4.87 | Mittelwert: 5.00 |

| Standardabweichung: 1.13 | Standardabweichung: 1.20 |

Sobald die Teilnehmenden keine Fragen mehr stellten, wurden sie aufgefordert, einen Fragebogen zur Beurteilung des Gesprächs auszufüllen. Der Fragebogen umfasste einleitend drei Fragen, die zur direkten oder indirekten Erhebung der Zufriedenheit dienten:

Wie zufrieden sind Sie mit der Nutzung der Chatfunktion?

Werden Sie die Chatfunktion beim Strassenverkehrsamt wieder nutzen?

Werden Sie die Chatfunktion beim Strassenverkehrsamt Ihren Freunden weiterempfehlen?

Die Beantwortung der Fragen erfolgte auf Likert-Skalen zwischen 1 (sehr negativ) bis 7 (sehr positiv). Ergänzend wurden Fragen zur Kontrolle von Störvariablen und der Erhebung von ergänzenden Informationen eingesetzt. Hier wurde ebenfalls mehrheitlich auf die Systematik der Likert-Skala gesetzt.

Die Auswertung der Rohdaten erfolgte mittels Excel. Dafür wurden verschiedene statistische Testverfahren angewandt. Als Basis diente der Zweistichproben-t-Test. Konnte dieser aufgrund fehlender Normalverteilung nicht angewandt werden, wurden Mann-Whitney-U-Tests durchgeführt. Die Kontrolle erfolgte mittels Shapiro-Wilk-Test. Zum Ausgleich der Geschlechter zwischen den Gruppen wurde eine Gewichtung mittels inverse probability weighting vorgenommen.

5 Resultate

In der Folge werden die Ergebnisse der Datenauswertung präsentiert. Der Aufbau des Kapitels orientiert sich dabei an den Hypothesen.

5.1 Einfluss des Chatpartners (Bot vs. Mensch)

Die Resultate der Nachbefragung zum Experiment zeigen, dass das Wissen, wer der Chatpartner sei (Bot oder Mensch) keinen Einfluss auf die Zufriedenheit zu haben scheint. Da der Shapiro-Wilk-Test für die beiden Stichproben ergeben hat, dass keine Normalverteilung der Werte vorlag (W Bot = 0.86, W Mensch = 0.63), wurde eine Analyse mittels Mann-Whitney-U-Test durchgeführt. Dieser zeigt keinen signifikanten Unterschied der Mittelwerte bei der Zufriedenheit auf (U = 67.50, p = 0.06, Alpha = 0.05). Da die Geschlechter in den beiden Vergleichsgruppen unausgewogen waren, wurden die Antworten mittels inverse probability weighting auf ein 50:50-Niveau ausgeglichen. Dabei zeigt sich ebenfalls, dass sich die Zufriedenheit in den beiden Gruppen nicht signifikant unterscheidet (U = 111, p = 0.95, Alpha = 0.05).

Die Anliegen der Probandinnen und Probanden konnten sowohl in der Bot- als auch in der Mensch-Gruppe ähnlich gut gelöst werden (MW Bot = 6.27, MW Mensch = 6.40; U = 105, p = 0.75, Alpha = 0.05).

5.2 Alter

Aufgrund der Altersstruktur der Stichprobe wird eine Subgruppe «90er» von Probanden mit Jahrgang 1990 – 1999 sowie eine Subgruppe «Übrige» mit den Jahrgängen 1953 – 1977 gebildet.

Die Auswertung der Zufriedenheit der Gruppe «Bot» zeigt, dass zwischen den Personen mit einem 90er-Jahrgang und den übrigen Probanden kein signifikanter Unterschied besteht (MW «90er» = 5.90, MW «Übrige» = 5.80 [vgl. Tabelle 4], U = 28, p = 0.71, Alpha = 0.05). Ein ähnliches Resultat zeigt sich bei den Probandinnen und Probanden aus der Untersuchungsgruppe «Mensch» (U = 17.5, p = 0.56, Alpha = 0.05). Innerhalb der Altersgruppen lassen sich ausserdem keine signifikanten Abweichungen in der Zufriedenheit zwischen den unterschiedlichen Chatgegenüber feststellen («90er»: U = 39.50, p = 0.28, Alpha = 0.05; «Übrige»: U = 3.5, p = 0.11, Alpha = 0.05).

5.3 Geschlecht

Auch bezogen auf das Geschlecht der Probandinnen und Probanden lässt sich kein signifikanter Unterschied in der Zufriedenheit in der Gruppe «Bot» feststellen (vgl. Tabelle 5: MW «männlich» = 5.80, MW «weiblich» = 5.90, U = 22, p = 0.71, Alpha = 0.05), ebenso bei der Untersuchungsgruppe «Mensch» (MW «männlich»= 6.64, MW «weiblich»= 6.50, U-Value 19, p-Value 0.70, Alpha 0.05). Innerhalb der Geschlechter lassen sich keine signifikanten Abweichungen in der Zufriedenheit zwischen den unterschiedlichen Chatpartner feststellen («männlich»: U = 11.50, p = 0.07, Alpha = 0.05; «weiblich»: U = 15, p = 0.48, Alpha = 0.05).

5.4 Vertrauen ins Internet

Das Vertrauen ins Internet wurde mit einer Likert-Skala von 1 bis 7 abgefragt. Als hohes Vertrauen wurden Antworten im Bereich von 5 – 7 gewertet, während Antworten mit einem Wert von 1 – 3 als tief eingestuft wurden. Der Wert 4 wurde als neutrale Antwort gewertet.

Zwischen den verschiedenen Ausprägungen des Vertrauens in Informationen aus dem Internet lassen sich keine signifikanten Differenzen feststellen («Bot»: U = 19.5, p = 0.33, Alpha = 0.05; «Mensch»: U-Value 22.5, p-Value 0.60, Alpha 0.05). Ebenfalls zeigen sich innerhalb der Levels des Vertrauens ins Internet keine signifikanten Abweichungen («hohes Vertrauen: U = 22.5, p = 0.34, Alpha = 0.05; «tiefes Vertrauen»: U = 12.0, p = 0.12, Alpha = 0.05).

5.5 Technisches Wissen

Das technische Wissen wurde nach Häufigkeit der Nutzung des Internets erhoben. 29 der 30 Probandinnen und Probanden nutzen das Internet mehrmals täglich. Eine Person nutzt es täglich. Aufgrund dieses einheitlichen Ergebnisses lassen sich keine Rückschlüsse auf den Einfluss des technischen Wissens auf die Zufriedenheit ziehen. Dieses Resultat ist möglicherweise auf das Setting des Experimentes zurückzuführen. Da die Rekrutierung der Teilnehmenden und die Durchführung ausschliesslich online stattfanden, wurden Personen mit tiefem technischem Wissen von der Stichprobe ausgeschlossen.

5.6 Soziales Unwohlsein

Das soziale Unwohlsein wurde mit einer Likert-Skala von 1 bis 7 abgefragt. Als hohes soziales Unwohlsein wurden Antworten im Bereich von 1 – 3 gewertet, während Antworten mit einem Wert von 5 – 7 als tief eingestuft wurden. Neutrale Antworten mit Wert 4 wurden nicht berücksichtigt. Das betraf je eine Antwort in der Bot- und Menschgruppe.

Es lassen sich keine signifikanten Abweichungen zwischen den Ausprägungen des sozialen Unwohlseins feststellen («Bot»: U = 21.5, p = 0.94, Alpha = 0.05; «Mensch»: U = 23.5, p = 0.89, Alpha = 0.05). Ebenfalls zeigen sich innerhalb der Ausprägungen der Sozialinteraktion keine signifikanten Differenzen («hohes soziales Unwohlsein»: U = 15.0, p = 0.32, Alpha = 0.05; «tiefes soziales Unwohlsein»: U = 12.5, p = 0.18, Alpha = 0.05).

6 Diskussion

Die vorliegende Studie konnte keine ihrer aufgrund der Theorie aufgestellten Hypothesen bestätigen. Die Resultate zeigen, dass sich die Zufriedenheit bei den Personen, die mit einem anderen Menschen per Chat interagierten, nicht von jener der Personen unterschied, die mit dem vermeintlichen Bot interagierten. Zudem konnte in beiden Gruppen das Anliegen ähnlich gut gelöst werden. Die Hypothese 12 muss also verworfen werden. Aoki (2020) attestierte den Menschen eine gewisse Angst vor maschinellen Entscheiden oder dem fehlenden Vertrauen darin. Eine andere Studie hingegen fand in Experimenten keinen Unterschied bezüglich des Vertrauens in Entscheidungen von Chatbots gegenüber Menschen (Alon-Barkat & Busuioc, 2023). Auch in der vorliegenden Studie scheint es für die Testpersonen keinen Einfluss zu haben, wer ihr Chatgegenüber sei, solange ihr Anliegen gelöst werden konnte. Dies zeugt von keiner grundsätzlichen Ablehnung der Leistungserbringung durch Chatbots. Auch die weiteren Hypothesen betreffend Alter, Geschlecht, Vertrauen ins Internet, technischem Wissen und sozialem Unwohlsein liessen sich keine signifikanten Abweichungen in der Zufriedenheit eruieren.

Auch wenn mit der vorliegenden Studie keine signifikanten Unterschiede bezüglich Zufriedenheit festgestellt werden konnten, bieten die Ergebnisse eine Basis für weitere Forschungsarbeiten und Informationen für die öffentliche Verwaltung. Die Zufriedenheit war sowohl beim Chatbot wie auch beim Chat mit einem Menschen generell hoch. Daher könnte der Chat auf der Webseite beispielsweise zukünftig das E-Mail als Kontaktkanal ersetzen oder zumindest eine gute Alternative für Telefongespräche bieten. Gerade Personen mit einem hohen sozialen Unwohlsein bevorzugen schriftliche Kanäle.

Eine Person, die bei der Entwicklung des Chatbots im Strassenverkehrsamt Aargau beteiligt war, hielt fest, dass mittels Live-Chats die Antworten deutlich schneller zugestellt werden könnten als bei klassischen E-Mail-Konversationen. Gleichzeitig könnten Bots eine bessere Erreichbarkeit ausserhalb der Büro-Öffnungszeiten sicherstellen und Menschen von repetitiven Aufgaben entlasten (Telefongespräch, 29.04.2022).

Eine weitere Möglichkeit böten Kurznachrichtendienste wie WhatsApp. Diese könnten als niederschwellige Option für den Kontakt mit den Behörden dienen. Im Gegensatz zum Live-Chat besteht hier kein Anspruch auf sofortige Rückmeldungen und der Verlauf bleibt bestehen (M. B., Telefongespräch, 29.04.2022). Dieser Kommunikationskanal wurde jedoch durch die Probandinnen und Probanden nicht als bevorzugter Weg gewählt. Dies könnte auf den niedrigen Bekanntheitsgrad von WhatsApp im Kontakt mit Behörden zurückzuführen sein.

Eine moderne Webseite mit einer gut ausgebauten Suchfunktion kann zudem die Funktionalität eines Chatbots teilweise substituieren. So erhalten die Nutzerinnen und Nutzer schnell die gewünschten Informationen und sie wenden sich erst bei komplexen Anfragen an die Hotline (M.B., Telefongespräch, 29.04.2022). Auch bei dieser Variante werden die Angestellten von repetitiven Aufgaben entlastet und die hohe Erreichbarkeit ist sichergestellt.

Es stellt sich generell die Frage, ob Chatbots auf den Webseiten von Verwaltungen überhaupt nötig seien. Weit entwickelte Chatbots wie «ChatGPT» könnten genutzt werden, um an einem einzigen Ort im Internet auf die Informationen sämtlicher Verwaltungs-Webseiten zuzugreifen. «ChatGPT» hat zum Zeitpunkt der vorliegenden Publikation zwar noch keinen Zugriff zu aktuellen Internetinhalten. Seit seiner Einführung wurden jedoch viele weitere KI-basierte Applikationen lanciert, unter anderem «Chatsonic», ein Chatbot, welcher jederzeit auf aktuelle Internetinhalte zugreifen kann. Bei einem Einsatz in der Verwaltung müsste hier ein besonderes Augenmerk auf Datensicherheit und Datenschutz gelegt werden (Pleger, Guirguis, & Mertes, 2021).

7 Fazit

Das Ziel der Studie lag darin, herauszufinden, ob die Kundschaft der öffentlichen Verwaltung zufriedener sei, wenn sie mit einem Chatbot oder einem Menschen via Chat interagierte. Daneben sollten auch andere Faktoren mit Einfluss auf die Zufriedenheit untersucht werden. Dadurch wird eine bestehende Forschungslücke geschlossen und die Amtsstellen erhalten Informationen zum Ausbau ihrer Servicedesks.

Die Resultate des durchgeführten Experiments zeigen bezüglich der Zufriedenheit keine signifikanten Unterschiede zwischen den beiden Gruppen (Mensch resp. Bot). Die Studie fand im Kontext eines Strassenverkehrsamts statt. Anfragen können hier relativ einfach und emotionslos beantwortet werden. In anderen Bereichen des öffentlichen Sektors ist dies sicherlich nicht der Fall (Wirtz et al., 2021). Dort ist ein Chatbot weniger geeignet. Weiter kann sich der Nutzen von Chatbots im öffentlichen Bereich zwischen verschiedenen Ländern unterscheiden. Relevant sind hier die Politsysteme und der Umsetzungsstand der digitalen Transformation (Wirtz et al., 2021).

Es kann angenommen werden, dass die Zufriedenheit mit Chatbots in der Zukunft zunehmen wird, da künstliche Intelligenz immer häufiger eingesetzt wird und sich aufgrund des technologischen Fortschritts weiterentwickelt.

Eine Limitation der Studie besteht darin, dass sich unter den Probandinnen und Probanden niemand befand, der sich im digitalen Umfeld nicht wohlfühlte. Es kann davon ausgegangen werden, dass die Zufriedenheit mit dem Chatbot niedriger gewesen wäre, wären auch solche Personen vertreten gewesen. Allgemein sind die Resultate nicht generalisierbar für die Schweizer Bevölkerung, da mehrheitlich junge Personen teilgenommen haben und auch, weil die Stichprobe selektiv ausgewählt wurde. Eine weitere Limitation bezüglich des Alters ist, dass die Zielgruppe “Übrige” Altersgruppe (1953 – 1977), bei der die grössten Widerstände gegenüber Chatbots vermutet werden könnten, unterrepräsentiert ist. Eine zusätzliche Limitation betrifft die Reaktionszeit des Chatbots. Da die Antworten im Experiment durch einen Menschen nicht so schnell erfolgten wie bei einem richtigen Chatbot, besteht die Möglichkeit, dass die Zufriedenheit geringer ausfiel.

Es wird weitere Forschung benötigt, um die genannten Limitationen zu beseitigen. Chatbots werden im öffentlichen Sektor noch nicht häufig eingesetzt und stellen für die Bevölkerung in diesem Kontext eine Neuheit dar. Eine Wiederholung des Experiments in der Zukunft würde daher sicherlich spannende Ergebnisse liefern. Aber auch ein qualitativer Ansatz wäre spannend, um vertiefte Erkenntnisse dazu zu erhalten, wie Chatbots im öffentlichen Sektor am besten zum Einsatz kommen könnten. Der Grossteil der bestehenden Forschung stammt aus Asien. Studien zum Schweizer Kontext würden also einen grossen Mehrwert bieten. Bei einer Wiederholung des Experiments müsste darauf geachtet werden, dass die Stichprobe grösser und für die Schweiz repräsentativer ist.

Hinweis: Dieser Artikel basiert auf einer studentischen Arbeit, die im Master in Business Administration – Major Public and Nonprofit Management an der ZHAW School of Management and Law im Frühlingssemester 2022 verfasst wurde.

Notes

[1] https://www.tawk.to/ (17.04.2023).

Konkurrierende Interessen

Die Autoren haben keine konkurrierenden Interessen anzugeben.